Umfeldsensorik: Vom Sehen zum Verstehen

Wie Datenfusion dem Fahrzeug einen siebten Sinn verleiht

- Continental bietet führende Technologien - wie etwa Radar, LiDAR und Kamera - für das assistierte und automatisierte Fahren an. Diese Sensoren fungieren als eine Art Augen der Fahrzeuge, die Umfeldinformationen sammeln.

- Durch Fusion der Sensordaten kann sich das Fahrzeug einen Überblick über die gesamte Verkehrssituation verschaffen, es erhält ein Szenenverständnis und kann Gefahrenpotenziale genau vorhersehen. Performance und Sicherheit der Systeme steigen. Continental setzt dabei auf einen Mix klassischer Methoden und Künstlicher Intelligenz (KI).

- Der Grad der Automatisierung der Fahrzeuge steigt in den kommenden Jahren weiter an und Autonomes Fahren wird massentauglich. Ab 2025 werden Level-3 und Level-4-Systeme kosteneffizient der breiten Masse zur Verfügung stehen.

Wie können Sicherheits- und Assistenzsysteme Gefahren und Hindernisse zuverlässig erkennen? Continental setzt auf einen „From Vision to Perception“-Ansatz. Fahrzeuge sollen Situationen im Verkehr nicht nur sehen (Vision), sondern auch verstehen (Perception) können. Damit Fahrzeuge so etwas wie einen siebten Sinn bekommen, auch komplexe Verkehrsszenarien interpretieren und entsprechend handeln können, werden verschiedenste Sensordaten miteinander fusioniert. Künstliche Intelligenz hilft dabei.

In modernen Fahrzeugen von heute kommen immer mehr und immer komplexere Technologien zum Einsatz. Schon heute gibt es zahlreiche Sicherheits- und Assistenzsysteme, die über Sensoren Umfeldinformationen sammeln und so den Fahrer dabei unterstützen, Abstand zu halten, in der Spur zu bleiben oder rechtzeitig zu bremsen (Level 2). Mit zunehmendem Grad an Automatisierung steigt auch die Zahl der Sensoren – und der Daten, die erhoben und interpretiert werden müssen.

Dabei haben die Sensoren ganz unterschiedliche Stärkenprofile und nur in der Kombination der verschiedenen Technologien ergibt sich eine vollständige und robuste Erfassung des Umfelds, die für höhere Automationsgrade unbedingt notwendig ist.

Über Sensoren das Unfallrisiko einschätzen

Doch in der Technik steckt noch viel mehr: Das Fahrzeug kann dank der Sensoren, die als Art Augen fungieren, das Verhalten anderer Verkehrsteilnehmer sehr gut interpretieren. Sprich: Wie groß das Unfallrisiko ist, ob ein Zusammenstoß droht oder ob davon auszugehen ist, dass ein Fußgänger in Kürze stehen bleibt oder die Straße überquert.

"Während ein Radar Distanzen zu und Bewegungen von Objekten sehr präzise erkennen kann, erlaubt die Datenfusion von Radar und Kamera, weitere Details zu erkennen. Beispielsweise ob es sich um Personen, Fahrradfahrer oder Kinderwagen handelt und wie sich diese verhalten. Ist der Fußgänger beim Überqueren der Straße aufmerksam? Schaut er in Richtung Fahrzeug und Verkehr, oder ist er abgelenkt? Hier bietet sich ein enormes Potenzial durch die Kombination von Sensor-Fusion und künstlicher Intelligenz." sagt Dr. Sascha Semmler, Leiter Program Management Camera der Continental Geschäftseinheit Fahrerassistenzsysteme.

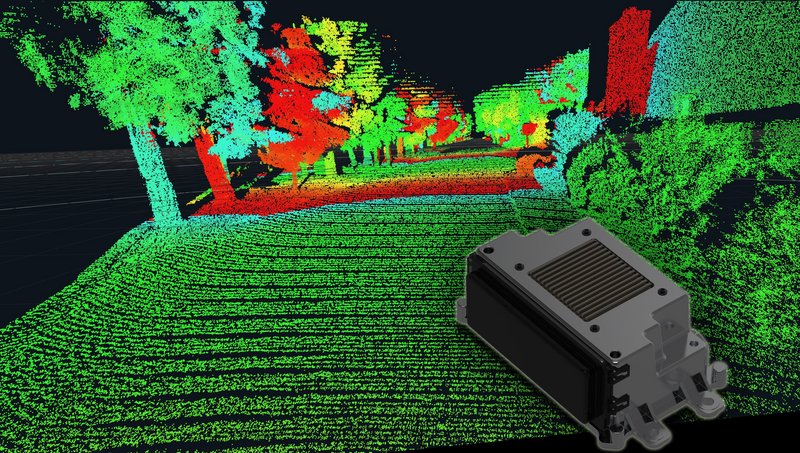

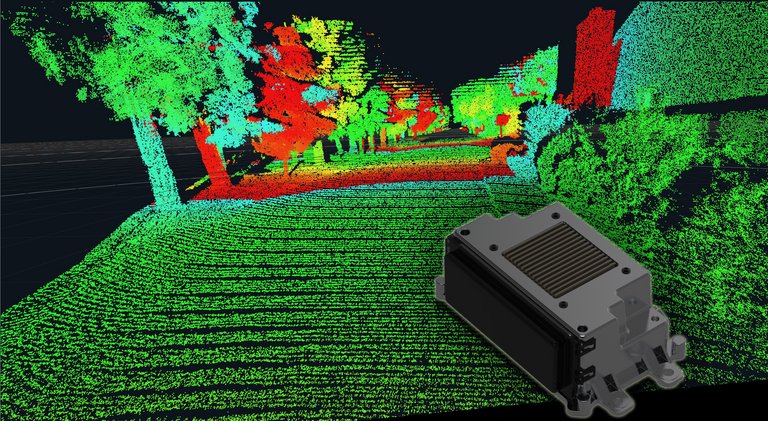

LiDAR als drittes Element der Umfeldwahrnehmung

In besonders herausfordernden Situationen, bei beispielsweise schlechter Sicht oder Dunkelheit, ergänzt der LiDAR als drittes Element die Umfeldwahrnehmung. Basierend auf 25 Jahren LiDAR-Erfahrung setzt Continental auf eine Kombination aus Nah- und Fernbereichslidaren. „In diesem Jahr wird unsere Nahbereichs-3D-Flash-LiDAR-Technologie mit einem Premium OEM in Serie gehen. Zusammen mit unserem Partner AEye entwickeln wir einen High Performance LiDAR für den Fernbereich, bei dem Fahrzeuge unabhängig von den Sichtverhältnissen in über 300 Metern Entfernung sicher erkannt werden können. Damit sind wir in einer hervorragenden Position, um das gesamte Fahrzeugumfeld mit hochmoderner LiDAR Technologie zu erfassen und so automatisiertes Fahren auf SAE Level 3 und höher, sowohl für PKW als auch in LKW Anwendungen, zu ermöglichen.“ erläutert Dr. Gunnar Jürgens, Leiter des LiDAR Segments der Continental Geschäftseinheit Fahrerassistenzsysteme.

Sensordaten zusammenbringen durch High- und Low-Level-Fusion

Für die Objekterkennung nutzt Continental verschiedene Ansätze, die High-Level-Fusion, die Mid-Level-Fusion und die Low-Level-Fusion. Bei der High-Level-Fusion erfolgt die Umfelderkennung zunächst separat für jeden einzelnen Sensor – also beispielsweise Erkennung von Objekten oder Spur- und Straßenverläufen. Diese Ergebnisse pro Sensor werden dann im Anschluss fusioniert und in der jeweiligen Fahrfunktion genutzt. Dieser klassische Ansatz wird bereits seit vielen Jahren erfolgreich eingesetzt und besitzt einen hohen Reifegrad.

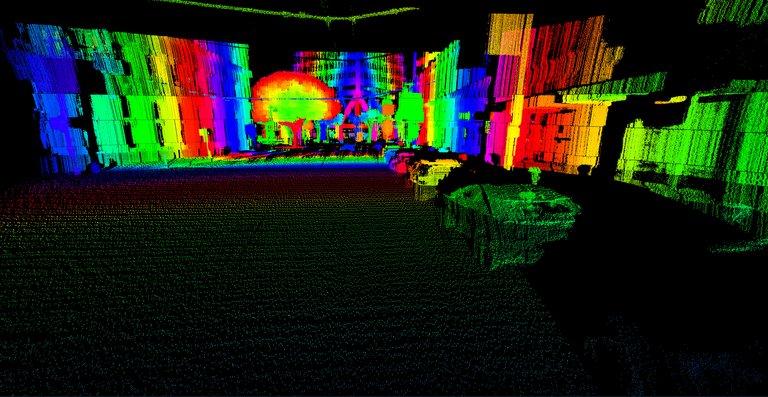

Doch für die Zukunft und vor allem für das Autonome Fahren ist die Low-Level-Fusion beziehungsweise ihre Kombination mit der High-Level-Fusion von elementarer Bedeutung. Hier werden die Sensorrohdaten direkt an einen leistungsfähigen Zentralrechner übermittelt, dort fusioniert und dann erst das Gesamtbild interpretiert. Die Folge: Eine deutlich höhere Performance der Systeme und ein “Szenenverständnis”, bei dem das Fahrzeug Verkehrsteilnehmer, Straßenverläufe, Gebäude etc. in Zusammenhang setzt und vielfältige Möglichkeiten bietet.

Umfeld in Detailtiefe erkennen und Verkehrsszenarien interpretieren

„Die Low-Level-Fusion ist unsere Stärke, mit der wir die Entwicklung automatisierter und autonomer Fahrsysteme des Level 3 und 4 vorantreiben“, erklärt Dr. Ismail Dagli, Leiter Forschung und Entwicklung der Continental Geschäftseinheit Fahrerassistenzsysteme. „Das Umfeld in solcher Detailtiefe zu erkennen, war Fahrzeugen vorher nicht möglich. Insbesondere durch Einsatz von Künstlicher Intelligenz in der Datenfusion und Situationsinterpretation weiß das Auto, was passieren wird, kann besser Rückschlüsse ziehen und Manöver durchführen.“ Aktuell sind Systeme, die mit Low-Level-Fusionen arbeiten, schon in gewissen Bereichen im Einsatz. 2025, so schätzt der Continental-Experte, könnten diese Systeme auch in der breiten Masse in Serie gehen – und so den Weg für kosteneffiziente L3 und L4 System ebnen.

Möglich wird der neue Ansatz der Low-Level-Fusion dank Künstlicher Intelligenz. Intelligente Algorithmen und neuronale Netze übernehmen, was klassische Methoden der Datenverarbeitung nicht mehr leisten können: Sie helfen bei der Klassifikation und Interpretation von komplexen Fahrsituationen, die mit klassischen Methoden nicht mehr programmiert werden können. Dabei werten die Algorithmen große Datenmengen binnen Sekundenbruchteilen aus und trainieren die Systeme für den späteren Einsatz. Auch können dank KI leichter neue Funktionen in die Technologien eingebaut werden. Bei neuen Entwicklungen wie etwa dem plötzlich vermehrt im Verkehr auftretenden E-Scootern können die Systeme nachtrainiert und über Over-the-air-Updates angepasst werden. Seine Kompetenzen im Bereich KI baut Continental kontinuierlich aus. Strategische Partnerschaften erhöhen die Innovationsgeschwindigkeit in diesem Bereich.

Vertrauen gewinnen durch Erkennen und Verstehen von Informationen

„Die Fahrassistenzsysteme, wie sie heute schon beim assistierten Fahren, dem sogenannten Level 2, zum Einsatz kommen, sind ein wichtiger Schritt auf dem Weg zum automatisierten Fahren, dem Level 4“, erklärt Dr. Ismail Dagli, Leiter Forschung und Entwicklung der Continental Geschäftseinheit Fahrerassistenzsysteme. „Es ist äußerst wichtig, dass diese Technologien zuverlässig funktionieren und damit unser aller Vertrauen gewinnen.“

Mit dem Grad der Automatisierung nimmt bei Autos auch die Anzahl der Sensoren zu. Während bei Level 2 noch eine Handvoll genügen, sind es bei der nächsten Evolutionsstufe schon zwei- bis fünfmal so viele. Da sind Datenfusionen auf KI-Basis unerlässlich, um ein vollständiges und korrektes Bild über die Verkehrssituation zu erhalten. „Die Systeme werden in Zukunft dem Fahrer immer mehr Aufgaben abnehmen. Noch steht dieser voll in der Verantwortung, hat das letzte Wort bei den Sicherheitssystemen und muss kontrollieren, ob sie richtig liegen. Das wird sich in den nächsten Jahren ändern.“